Systeme mit künstlicher Intelligenz werfen in der Praxis auch Haftungsfragen auf. Welche Parallelen hier zur Tierhalter- und Gefährdungshaftung gezogen werden können, beantwortet in einem Kommentar Katharina Bisset.

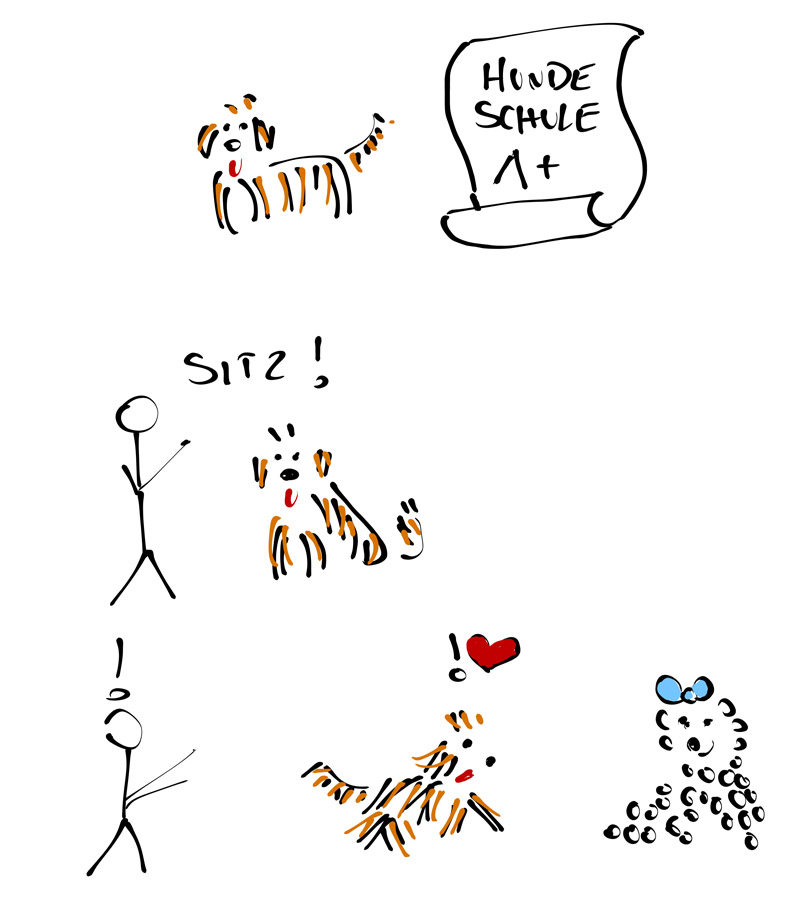

Stellen wir uns vor, eine AI ist ein junger Hund, nennen wir ihn Finn. Die Hundehalterin hat sich die Rasse ausgesucht, nach den Eigenschaften und dem Charakter der Eltern. Die Züchter haben auf Erbkrankheiten und vieles mehr geachtet. Finn hat auch schon viel gelernt – zum Beispiel war er in der Hundeschule. Die Trainer dort haben ihm auf Basis ihrer Erfahrung viel beigebracht, zum Beispiel funktioniert das Kommando »Sitz« schon ausgezeichnet. Bisher funktioniert auch alles gut, Finn hatte keine negativen Erfahrungen. Bis eines Tages eine hübsche Hundedame seinen Weg kreuzt – und Finn alles vergisst, was er jemals gelernt hatte. Was bedeutet das für künstliche Intelligenz in der Praxis? Wer haftet für Schaden durch eine AI?

Wenn Haftung geprüft wird, stellt man sich insbesondere folgende Fragen, aber bei AI gibt es einige Unsicherheiten:

Gibt es einen Schaden?

Das ist meistens das kleinste Problem.

Wer hat den Schaden verursacht?

War die Handlung kausal für den Schaden? Hier wird es spannender – je weniger man von einer AI versteht, umso weniger kann beurteilt werden, wo der Fehler lag. War es der Hersteller, der etwas falsch produziert hat? Der Eigentümer oder Benützer, der die AI falsch eingesetzt hat, oder die Person, die der AI etwas beigebracht hat? Hier ist es in der Praxis wichtig zu wissen, was passiert ist, und es im Streitfall beweisen zu können.

Wurde rechtswidrig gehandelt?

Das bedeutet, ob die Handlung, die den Schaden verursacht hat, gegen einen Vertrag, ein Gesetz oder die guten Sitten verstoßen hat. Da ist die Beurteilung nach allgemeinen Grundsätzen noch gut möglich, aber je mehr man hier in nicht regulierte Bereiche kommt, umso wichtiger ist es, diese Themen in einem Vertrag zu handeln.

Ist die Handlung vorwerfbar?

Trifft den Schädiger ein Verschulden? Gerade bei der Frage, ob ein Verhalten einem sorgfältigen Menschen auch passiert wäre, stößt man oft an die Grenzen der Technik. Bei Innovationen ist es oft schwer zu sagen, ob es fahrlässig ist, dass man eine bestimmte Technik noch nicht kennt, oder von einer neuen Gefahr noch nichts weiß. Der Sorgfaltsmaßstab wird aber höher anzusetzen sein, wenn ein Unternehmen beispielsweise auf die Erstellung von AI spezialisiert ist (Sachverständigenhaftung). Spannender wird die Frage, wenn eine Handlung eine Konsequenz hat, mit der man nicht rechnen konnte. Oft fällt man hier aber schon bei der Kausalität aus der Prüfung.

Als Konsequenz bedeutet das, im Gesetz wird man nicht immer alle Antworten finden. Umso wichtiger ist es, dass diese Punkte in Verträgen mitgedacht werden – insbesondere zwischen dem Hersteller der AI und seinen Kunden.

Für Finn und seine Halterin heißt das: Wenn er der Hündin nachläuft und einen Schaden verursacht, stellt man sich die Frage, ob man damit rechnen konnte, ob man Vorkehrungsmaßnahmen treffen musste – stärkere Leine – und ob eine sorgfältigere Hundehalterin auf diese Dinge geachtet hätte.

Hier ist der Gesetzgeber gefordert. In der Praxis werden viele Haftungsthemen an dem praktischen Problem scheitern, dass man bei selbstlernenden AI oft nicht weiß, wie es zu einer Entscheidung kam und was diese beeinflusst hat.

Es gibt zwei Konzepte, die hier gut passen könnten – einerseits die Tierhalterhaftung, die besagt, dass der Halter dafür Sorge tragen muss, dass ein Tier keinen Dritten schädigt. Hier gibt es Spielraum für außergewöhnliche Umstände, aber der Halter haftet grundsätzlich mehr. Ähnlich verhält es sich bei einer Gefährdungshaftung, die zum Beispiel beim Betrieb eines Kfz, Eisenbahn und vieles mehr greift. Hier ist der Sorgfaltsmaßstab dessen, der ein Auto fährt, viel höher als bei einer normalen Haftung. Das Prinzip dahinter ist: Wenn man eine gefährliche Tätigkeit durchführt und auch die Vorteile daraus hat, muss man auch sorgfältiger sein. Bei selbstfahrenden Autos wird es dann noch um eine Stufe spannender.

In jedem Fall gilt: Je mehr man versteht und beweisen kann – desto besser!

Illustration: Katharina Bisset

Über die Autorin: Katharina Bisset ist Rechtsanwältin und Co-Founder von Nerds of Law. Sie hat sich auf Gebiete mit technischem Hintergrund spezialisiert, wie IT-, E-Commerce, IP, Datenschutz- und Medienrecht.

How to resolve AdBlock issue?

How to resolve AdBlock issue?